无人机避障算法综述(五)

转自:无人机

作者:张宏宏,甘旭升,毛 亿,杨春林,谢晓伟

2.3 基于机器学习的避障方法

机器学习算法是将无人机避障问题转化为一个决策问题,通过与复杂动态环境的信息反复交互,选择最优或近最优策略,以实现其长期目标。随着智能化水平的不断提升,机器学习算法在无人机避障领域得到广泛应用,常见方法有神经网络、强化学习与深度强化学习。

2.3.1 神经网络

无人机避障导航控制是根据传感器获取的信息,快速得到无人机应采取的动作,其本质是获取状态空间与动作空间的映射关系[66]。映射关系往往难以用精确的数学表示,而神经网络是由大量非线性单元连接构成的非线性复杂网络结构,通过对人脑功能的控制与反馈功能进行模拟,形成的非线性映射系统[67]。神经网络凭借其强大的学习与泛化能力、非线性映射能力以及快速规划能力,在机器人动力学以及导航控制领域得到广泛应用。

国内外学者结合神经网络的特点,对无人机路径规划、制导与避障控制进行了大量研究。王延祥等[68]提出扰动流体动态系统与神经网络结合的自适应避障路径生成算法,能够适应环境的复杂性,且具有较高的鲁棒性。Zhang等[69]基于神经网络模型,不断对无人机进行离线训练,找到符合约束条件的解脱路径。Choi等[70]采用机器学习框架,提出了一种无人机双层避障算法, 使得无人机以最小的支付代价避障多个障碍物,得到满足实时性和有效性的避障决策。

单一神经网络未能考虑训练与决策过程中的不确定性,因此有学者将模糊逻辑理论与神经网络相结合,用隶属度代替不确定性的指标,更符合实际情况,具有较强的自学习与自适应能力[71-72], 以适应环境变化。

2.3.2 强化学习

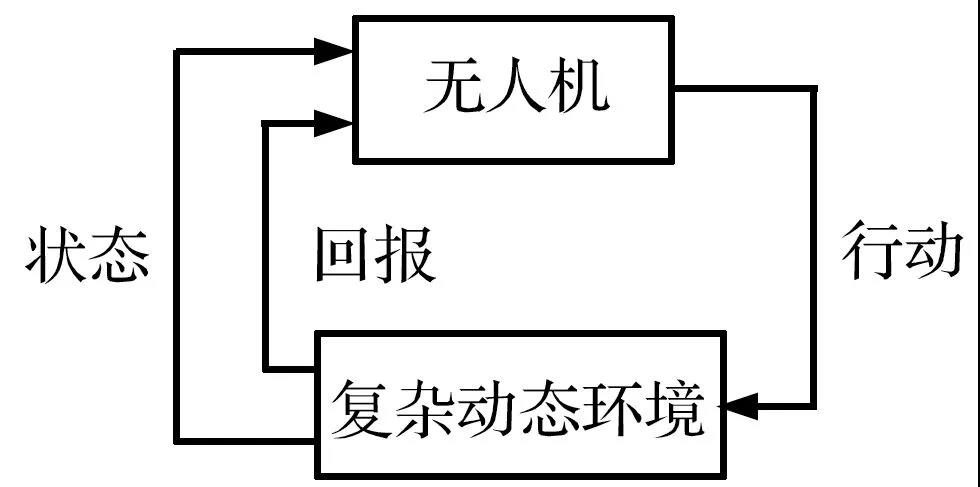

强化学习是将动态规划与监督学习相结合的一种新型学习方法,强调在于环境的交互中不断学习,执行“尝试-失败”机制,通过反馈的评价,实现输出最优决策,在无人机复杂避障决策问题得到应用。这种学习理念能够通过奖励指标最大化,使得系统做出一系列决策,而不需要人工干预,流程图如图6所示。2005年,Michels J等[73]将强化学习应用在避障系统中,通过训练模型预测合适的避障策略。Xie等[74]基于Double DQN 算法,实现了室内场景自主避障。Vamvoudakis等[75]也将强化学习应用在智能体避障领域,但实验表明样本特征质量的选择影响避障效果。邹启杰等[76]提出强化学习驱动快速探索随机数的RL-RRT方法,加快搜索速度,实现解脱路径多目标决策优化。Kulkarni等[77]基于目标驱动内在动机的深度学习方法,在实时环境中学习导向行为,以提高复杂环境内收敛速度。

图6 强化学习流程图

Fig.6 Reinforcement learning flow chart

目前,强化学习在无人机避障领域已取得不错的进展,只需对环境样本进行训练,便可得到避障模型,同时具有规划速度快的特点,但是,当运行场景发生变化时,往往需要重新对模型进行训练,代价相对较高。

2.3.3 深度强化学习

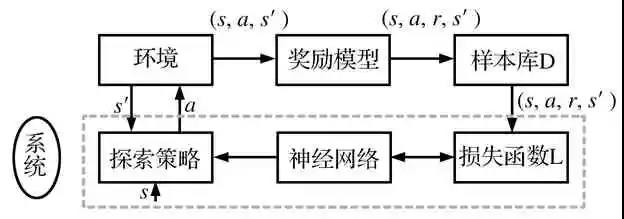

深度强化学习(Deep Reinforcement Learning, DRL)是将强化学习与深度学习相结合,通过强化学习与环境探索得到优化目标,通过深度学习获取系统运行机制,用于表征和解决问题[78]。作为机器学习中的研究热点,该方法凭借深度学习的感知能力,即使针对高维原始数据输入,也能获取有效的控制决策。基于深度强化学习的系统避障控制模型如图7所示,可分为基于值函数和基于策略梯度的深度强化学习算法。

图7 基于深度强化学习的系统避障控制模型图

Fig.7 Model diagram of system obstacle avoidance control based on DRL

(1)基于值函数的深度强化学习算法

DQN(Deep Q-Learning)算法由DeepMind公司在NIPS2013上提出,后于2015年在Nature上提出改进版本[79]。其核心思想是用神经网络来表征函数或者参数化动作策略,基于梯度对损失函数进行优化,实现了“感知-动作”的学习算法。Lü等[80]提出了一种改进的学习策略,该策略基于不同学习阶段对经验深度和广度的不同需求,其中DQN计算Q值,采用密集网络框架。在学习的初始阶段,创建一个经验价值评价网络,增加深度经验的比例,以更快地理解环境规则。当发生路径漫游现象时,采用平行探索结构,考虑漫游点等点的探索,提高了经验池的广度。刘庆杰等[81]采用改进DQN算法克服了Q-learning表格式算法在连续状态下导致内存不足的局限性。通过改进奖励机制,增加实时奖惩作为补充,解决学习耗时长和训练不稳定的问题。

DQN在无人机避障控制领域取得不错效果,但其动作空间是离散形式的,不能实现连续的路径生成。

(2)基于策略梯度的深度强化学习算法

为实现连续的状态空间和动作空间,梯度策略直接利用梯度参数优化策略,不计算执行策略获取的累计奖励值,输出完整动作策略,而不是输出状态动作值函数。最先广泛应用的是随机策略搜索法中的区域信赖策略优化算法(Trust Region Policy Optimization, TRPO)。该算法由Schulman等[82]提出,通过进行数据新旧策略分布评估,应用于无人机导航控制领域。此外,深度确定性策略梯度算法(Deep Deterministic Policy Gradient, DDPG)[83]、引导性策略梯度算法(Guided Policy Search, GPS)[84-85]和分布式近似策略优化算法(Distributed Proximal Policy Optimization, DPPO)[86]等算法,也在逐步应用于无人机避障控制中。

但基于策略梯度的深度强化学习算法存在收敛难度大的问题,具体在复杂障碍场景下的样机试验还需进一步研究。

(关键词:无人机,无人机反制,反制无人机,黑飞无人机,无人机防御,防御无人机,反无人机,无人机管控,无人机黑飞,无人机管理)

无人机避障算法综述(四)